Key Takeaways

- Definisci una chiara ipotesi di partenza: Un’ipotesi ben strutturata è fondamentale per un test A/B efficace.

- Seleziona un campione adeguato: Utilizza tool come quello di Evan Miller per calcolare il campione necessario, evitando test su e-commerce con poco traffico.

- Determina la durata del test: I test dovrebbero durare non oltre 3-4 settimane per evitare errori e inquinamenti esterni.

- Utilizza i giusti strumenti: Strumenti come Google Optimize, VWO e Convertize possono aiutarti a gestire e interpretare i tuoi test A/B.

- Analizza e archivia i risultati: Analizza i risultati segmentati per diversi tipi di utenti e archivia i test per future strategie di marketing.

Il mondo si divide in due grandi, enormi gruppi.

Ricchi e poveri? No.

Fan dei Beatles e fan dei Rolling Stones? No di nuovo.

Ti parlo del mondo del digital marketing: da una parte c’è chi ama i test A/B e che quindi vorrebbe testare qualsiasi cosa almeno una decina di volte, dall’altra c’è invece chi li odia e preferirebbe fare tutt’altro.

In realtà, i test A/B possono piacere o meno, ma il concetto di base non cambia: fare dei test A/B per e-commerce ci aiuta ad aumentare le conversioni, ergo ad aumentare le vendite.

Ovviamente questo vale solo e unicamente quando i raffronti vengono eseguiti a regola d’arte, ed è qui che casca l’asino, in quanto in tantissimi casi – anche quando eseguiti da marketer professionisti – i test A/B vengono realizzati in modo distratto e frettoloso.

Le decisioni che vengono prese a partire da quei risultati inaccurati, infatti, non possono che essere grossolane e, nei casi peggiori, controproducenti.

Per porre fine alla piaga delle comparazioni mediocri tra le pagine web dei negozi online ho dunque deciso di confezionare questa succosa guida sui test A/B per e-commerce: parlerò quindi di matematica, di statistica e di strumenti disponibili online.

Cerchi un partner di esperienza per lanciare il tuo nuovo e-commerce?

Dall'analisi del tuo mercato, attraverso neuromarketing e psicologia della persuasione, sviluppiamo e promuoviamo esperienze digitali ad alto tasso di conversioneQuelli del primo gruppo arriveranno in fondo al post con un bel sorriso sulla faccia, pienamente soddisfatti; gli altri, invece, giungeranno alle ultime righe un po’ più provati, e probabilmente meno sorridenti. Tutti quanti, però, a partire da domani, potranno iniziare a fare dei test A/B significativi per i propri e-commerce. E sì, finalmente anche quelli del secondo gruppo inizieranno a sorridere ripensando a questo – lungo – post.

Qualsiasi sia la tua opinione in merito, dunque, il mio consiglio è quello di buttarti di pancia nella guida sui test A/B: ti assicuro che sarà un ottimo investimento di tempo!

Cosa sono i test A/B?

Non è per nulla difficile spiegare cosa è un test A/B – che a volte viene chiamato anche Split test. In parole semplici, infatti, si tratta un processo di comparazione tra due differenti versioni della stessa pagina web, allo scopo di capire quale può assicurare migliori risultati. Fin qui sembra tutto molto facile, no?

Ecco, il problema è che, ancora prima di effettuare test A/B sul tuo e-commerce, devi decidere cosa vuoi testare e cosa vuoi cambiare. Una volta eseguito il test, poi, devi essere in grado di interpretare correttamente i risultati e questo non è assolutamente scontato

Come funzionano i test A/B?

Per effettuare un test A/B per il tuo e-commerce devi come prima cosa creare una seconda versione della tua pagina originale: questa seconda pagina (B, anche detta ‘variante’) deve avere un solo elemento differente rispetto alla pagina A (anche detta ‘controllo’). Metà del pubblico vedrà la versione A, mentre l’altra metà vedrà solo la versione B.

Messa giù in modo molto semplice, possiamo dire che la versione che, tra le due, otterrà il più alto tasso di conversione, vincerà.

Ipotizziamo che tu vada a cambiare il copy di una landing page, creando una pagina B. Bene, ipotizziamo anche che, alla fine del tuo test A/B, la variante vinca: la tua pagina B diventerà così la tua nuova pagina A di controllo per un successivo test A/B, in cui creerai una nuova variante (come vedremo più avanti, infatti, non si finisce mai di fare queste comparazioni).

Si possono creare anche dei test che confrontano una pagina di controllo con più di una variante: in questo caso si parla di A/B/n test.

Se ti trovi ad avere una pagina di controllo e tre varianti, devi dividere il pubblico in 4 fette, ognuna composta dal 25% del totale. Sia chiaro che stiamo pur sempre parlando, anche in questo esempio, di un puro meccanismo A/B testing, e non di test multivariati: qui,infatti, non vi sono variazioni multiple da considerare. I test multivariati sono più complicati da pianificare e da gestire e in ogni caso richiedono molto più traffico a disposizione per essere significativi.

Occhio però, questa è la costante più importante: il tasso di conversione non è una misura perfetta come si potrebbe dapprima pensare.

Certo, quel dato può dirti senz’altro quale pagina funziona meglio, ma questo non significa automaticamente che quella pagina sarà ‘migliore’ per il tuo business. Pensaci un po’: per assurdo, potresti creare due versioni della medesima scheda prodotto, inserendo nella seconda uno sconto del 70%. È piuttosto ovvio che questa seconda pagina risulterà vincente, ma il tuo business può davvero sopravvivere con questi sconti?

I test A/B, insomma, vanno sempre creati e interpretati in base alle proprie reali esigenze.

Quanto dovrebbe durare un test A/B?

Ecco qui una domanda che si pongono in molti: quando si può affermare che un test A/B è terminato, e che dunque si può proporre all’interezza del pubblico la pagina vincente?

Ebbene, non è facile dare una risposta unica. Anzi, è proprio impossibile, in quanto la durata di un test A/B cambia di caso in caso.

Prima di tutto posso dirti che, in un universo ideale, ogni test A/B dovrebbe essere monitorato in termini di risultati per 2 interi cicli di business, ma fatto girare non oltre le 3 o 4 settimane

Perché porre un tale limite? Semplice, poiché più si farà correre il test, più questo sarà suscettibile a errori e a inquinamenti esterni. Pensa per esempio a tutti gli utenti che, in quelle settimane, cancelleranno dalla cronologia i propri cookies, finendo così per tornare come ‘nuovo’ visitatore all’interno del test. O pensa a quegli utenti che, visitando il tuo e-commerce sia da desktop che da smartphone, vedranno entrambe le versioni. Insomma, all’aumentare dei giorni aumentano anche i possibili errori.

Si è però parlato di due interi cicli di business. Perché? Beh, perché in questo modo si possono raccogliere anche i dati relativi ai visitatori che si prendono una fetta maggiore di tempo per decidere, perché così facendo è possibile fare affidamento su un’ampia gamma di fonti di traffico (dai social alla ricerca organica) e perché si potranno appianare più facilmente determinate anomalie.

In ogni caso, va sottolineato che la durata di un test A/B è determinata anche e soprattutto dalla grandezza del campione necessario per avere dei risultati statisticamente significativi. Ogni test A/B infatti deve essere effettuato su un campione sufficiente, la cui ampiezza va ricavata in base ai risultati che si vogliono raggiungere. I calcoli da fare, in questo senso, non sono per nulla semplici e immediati ma, per nostra grande fortuna, esistono parecchi tool online che possono aiutarci in questo senso.

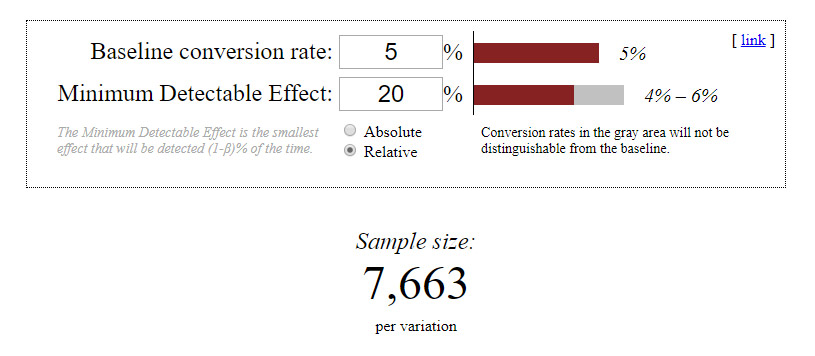

Lo strumento sviluppato da Evan Miller, in base a due fattori chiave (ovvero Baseline conversion rate e Minimum detectable effect), ci dice quale deve essere il campione minimo al quale sottoporre la nostra variante.

Ipotizzando un Baseline conversion rate del 5% e un Minimum detectable effect del 20%, il campione minimo calcolato dal tool è di 7.663, il che ci dice che, per un normale Test A/B, sono necessari oltre 15.000 visitatori.

A questo punto la domanda, prima di procedere, nasce spontanea: il tuo e-commerce può contare su questa mole di traffico in un periodo non superiore alle 3-4 settimane (per non andare incontro a possibili inquinamenti come abbiamo visto sopra)?

Il campione necessario, inoltre, inizia ad aumentare col diminuire dell’effetto da analizzare: con un Baseline conversion rate del 5% e un Minimum detectable effect del 12%, il campione minimo calcolato dal tool è di 21.060.

Inutile sottolineare che l’ampiezza del campione da prendere come riferimento va calcolata prima dell’inizio del test: questo, una volta avviato, non potrà essere fermato fino a quando tutti gli utenti necessari saranno stati raggiunti. Qualsiasi altro limite determinato in modo diverso, a conti fatti, risulta dunque impreciso, tale – in alcuni casi – da minare la validità di un test.

Quale senso ha, in termini statistici, decidere di fermare qualsiasi tipo di test A/B per e-commerce dopo le prime 100 conversioni?

In base a cosa si dovrebbe tenere per buono quel determinato limite?

Ci sono altri tipi di tools che, partendo da ragionamenti simili, stimano direttamente quanti giorni saranno necessari per arrivare alla fine del nostro test A/B: un esempio è VWO, il quale, a partire dall’incrocio di 5 fattori, ci dice quanto dovrebbe durare la comparazione.

Quanto deve durare, invece, un test A/B su una campagna di email marketing?

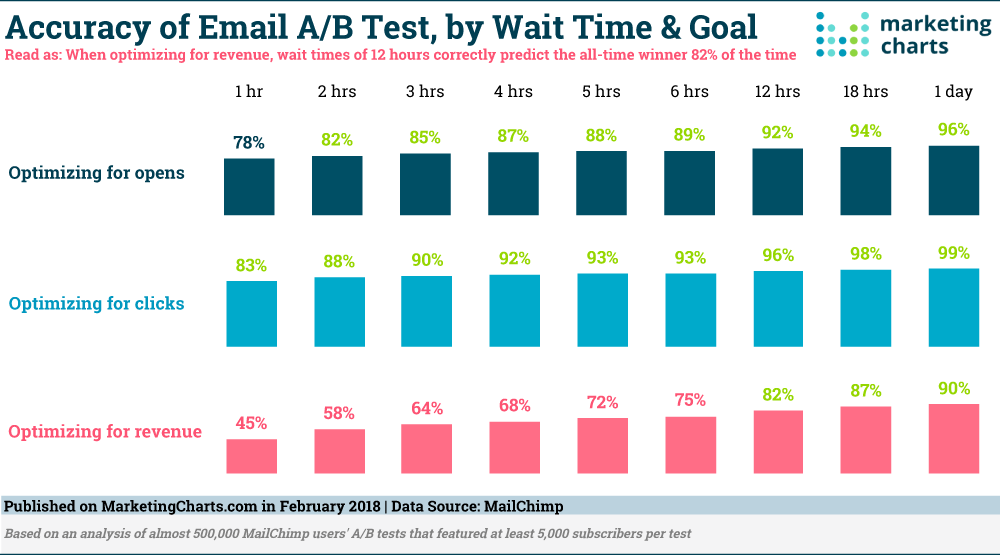

È leggermente diverso il discorso per quanto riguarda i test A/B relativi all’email marketing. In questo caso vanno evidenziati i risultati di uno studio condotto da MailChimp – la famosa piattaforma di email marketing – teso a stimare il tempo necessario ad un test A/B per determinare la versione vincitrice di una email. Per l’occasione sono stati presi in considerazione diversi parametri (open rates, click rates, revenue), tutti messi in relazione ad un limite minimo di precisione dell’80%.

Ebbene, per quanto riguarda i tassi di apertura, dopo 1 sola ora è stato possibile identificare quello che, nel 78% dei casi, si è rivelato essere il modello vincente. Dopo 2 ore, invece, si è arrivati ad un soddisfacente 83%, per poi toccare la soglia del 90%, allo scoccare delle 12 ore.

Non molto diverso il discorso per i click rates: dopo un’ora si può aspirare ad avere il vincitore con l’83% di precisione, per balzare al 90% già nell’arco delle prime tre ore. Più lunghi i tempi per quanto riguarda la revenue: al fine di avere dei dati affidabili per ottimizzare questo parametro è infatti necessario aspettare 12 ore (82%).

In base a cosa puoi decidere se un test A/B può aiutare il tuo e-commerce?

Ti ho spiegato che i test A/B possono aiutarti ad aumentare le conversioni del tuo e-commerce, sviluppando delle nuove e sempre più efficaci strategie. Ciò che non ti ho detto però è che non rappresentano sempre e in tutti i casi la soluzione più efficace. Anzi, talvolta il loro impiego finisce per essere totalmente inutile.

Come puoi avere intuito arrivando a questo punto, infatti, i test A/B non sono indicati per quegli e-commerce caratterizzati da un basso livello di traffico: in quei casi, infatti, finiresti per lasciar correre i test troppo a lungo, con risultati irrimediabilmente inquinati, che porterebbero a decisioni inesatte.

Se dunque, utilizzando i tool che abbiamo visto sopra, ti renderai conto di non poter effettuare il test desiderato in un ristretto arco di settimane, ti consiglio di cambiare test, o di cambiare totalmente strategia.

#testab #cro #ecommerce

Cosa testare con un A/B test?

Online puoi trovare tante liste di marketer che, con più o meno senso, ti propongono quali elementi del tuo e-commerce sottoporre a dei test A/B. Parliamo delle headline, dei copy, delle call to action, delle form di completamento e via dicendo. Ma tali liste possono in realtà aiutarti marginalmente: solo l’analisi attenta del tuo sito può infatti dirti con assoluta sincerità quali elementi dovresti sottoporre a test.

Senza sapere quali sono i tuoi specifici dati di insight e quanti e quali sono i tuoi clienti, infatti, diventa impossibile decidere così, su due piedi, cosa andare a testare.

Per capire quali elementi e quali pagine mettere al centro dei tuoi test A/B, invece di ricorrere a delle liste precompilate online, dovresti piuttosto porti delle domande specifiche intorno al tuo e-commerce.

- Cosa blocca i tuoi visitatori dall’acquisto? Potresti domandarlo direttamente agli utenti, attraverso degli appositi popup

- Il tuo e-commerce si carica in modo veloce e corretto, su qualsiasi tipo di dispositivo e con qualsiasi browser? Ovviamente degli eventuali rallentamenti possono influenzare negativamente il tuo tasso di conversione: analizza i dati per ogni dispositivo/browser

- I tuoi strumenti di analytics stanno funzionando bene? I dati sui cui basi le tue nuove strategie sono corretti e affidabili? Forse non ci hai mai pensato, ma una configurazione scorretta di un tool di analytics può sballare completamente i risultati, rendendo superflua o persino dannosa ogni tattica successiva.

- Perché i tuoi clienti hanno scelto il tuo e-commerce e non quello del tuo diretto concorrente? Quale esigenza precisa li ha spinti a fare acquisti sulle tue pagine? Pianificare con attenzione le domande da fare durante delle interviste telefoniche ai tuoi clienti può aiutarti moltissimo a migliore ulteriormente le performance del tuo portale

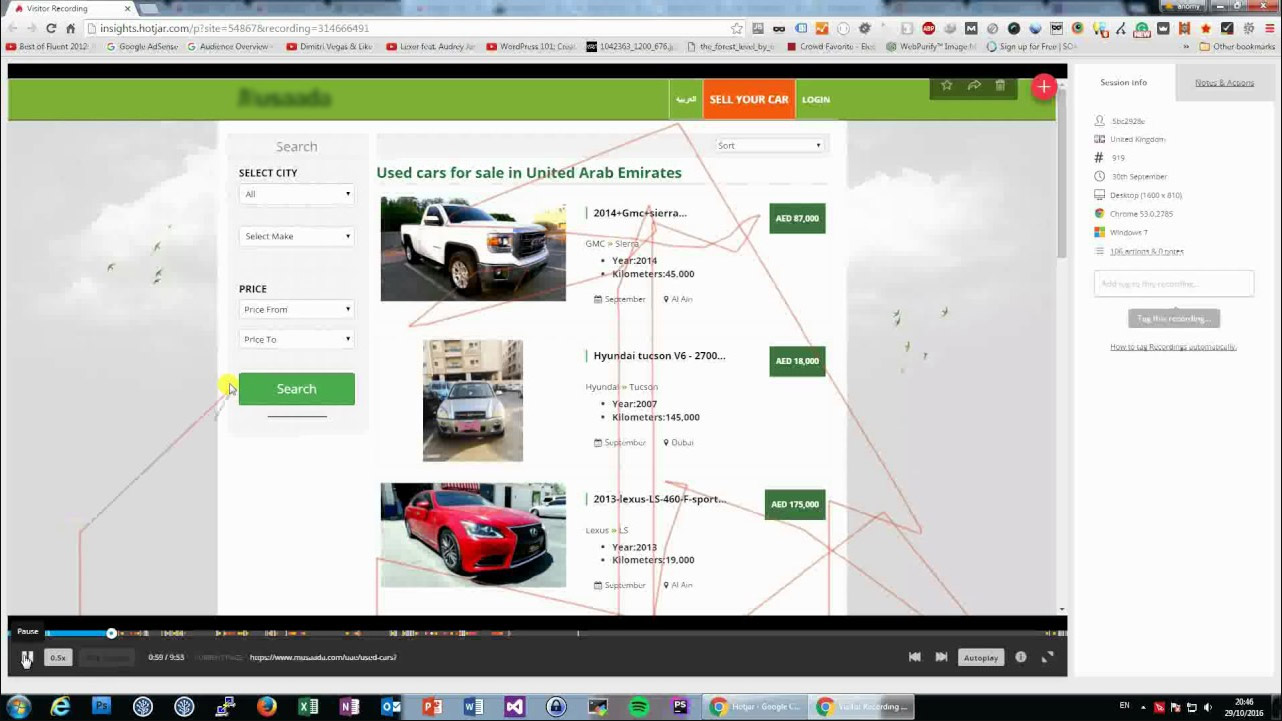

- Cosa mette in difficoltà i tuoi utenti? Cos’è che effettivamente può generare della frustrazione durante il processo di acquisto? Puoi scoprirlo attraverso i cosiddetti Session Replays i quali, mettendoti di fronte al comportamento reale dei visitatori, sono molto più efficaci delle semplici interviste.

È tutta una questione di statistica

Ho fatto menzione di alcuni utili strumenti per pianificare dei test A/B. Non ci si può però affidare a questi tool senza avere una conoscenza perlomeno basilare delle statistica: come anticipato, è necessario sapere individuare i requisiti giusti per effettuare le comparazioni, ed è poi fondamentale essere in grado di interpretare in modo corretto i risultati.

Per questo motivo ho deciso di inserire in questa guida di test A/B per e-commerce anche la spiegazione di alcuni concetti di statistica, per andare a rispolverare quello che hai imparato a scuola e che, molto probabilmente, hai dimenticato.

La media

Elemento fondamentale di ogni indagine statistica è il valore medio. Come si trova la media? Ipotizziamo che tu, per il tuo e-commerce di scarpe, debba trovare il prezzo medio di tutte le scarpe di ginnastica. Per arrivare a questo numero non andrai a sommare i prezzi di tutte le scarpe ginniche esistenti al mondo, no, andrai invece a isolare un ristretto numero di rappresentanti (ovvero un campione rappresentativo dell’intera popolazione di scarpe) e, in base a quelli, otterrai una stima più o meno esatta del prezzo medio. Il valore, ovviamente, sarà quanto più affidabile quanto più il campione selezionato sarà ampio e rappresentativo.

La varianza

La formula per ricavare la varianza, ad una prima occhiata, può sembrare ostica (si parla infatti della media dei quadrati degli scarti di ogni singolo valore dalla media). Spiegata a parole, però la faccenda è molto più semplice: la varianza ci dice infatti quanto è accurata la media se raffrontata alle rilevazioni totali. Più sarà alta la varianza, meno precisa sarà la media se confrontata con un dato individuale.

Il campione

Non parliamo di Roberto Baggio, né di Jury Chechi. Parliamo di un sottoinsieme rappresentativo della popolazione. Più largo è il campione, più sarà accurata la media. Riprendendo l’esempio delle scarpe, il prezzo risultante sarà molto più veritiero se calcolato su un campione di 500 scarpe piuttosto di un campione di sole 100 scarpe.

La significatività statistica

Più basso è il livello di significatività statistica, maggiori sono le possibilità che il modello vincente (A o B) non sia affatto un vincitore. Con una significatività bassa, infatti, si potrebbe avere a che fare con un rischioso falso positivo.

E qui si capisce perché è importante conoscere le basi della statistica pur appoggiandosi a dei tool appositi. Nella maggior parte dei casi, infatti, gli strumenti per i test A/B parlano di significatività statica senza tenere in considerazione la dimensione del campione o il tempo necessario.

Si deve dunque capire che, di per sé, parlare di un alto valore di significatività statistica può essere del tutto inutile se il campione preso in considerazione è troppo ridotto, o se il test è stato fatto correre per troppo poco tempo – non raggiungendo quindi un quota minima di utenti.

La regressione alla media

La regressione alla media è un fenomeno per il quale, se un qualsiasi elemento risulta ‘estremo’ ad una prima misurazione, molto probabilmente risulterà meno estremo e quindi più vicino alla media nella seconda misurazione. É per questo motivo che, in alcuni casi, si notano delle fluttuazioni decisamente marcate nelle prime fase degli A/B test.

Cerchi un partner di esperienza per lanciare il tuo nuovo e-commerce?

Dall'analisi del tuo mercato, attraverso neuromarketing e psicologia della persuasione, sviluppiamo e promuoviamo esperienze digitali ad alto tasso di conversioneLa potenza statistica

Partendo dal presupposto per cui esiste una differenza tra A e B, il dato relativo alla potenza statistica ci dice quanto spesso potrai vedere effettivamente l’effetto di questa differenza. Se ne può dunque dedurre che, minore sarà la potenza statistica, maggiori saranno le possibilità che il modello migliore non venga riconosciuto come tale. Ti basti sapere a questo punto che lo standard di potenza statistica, per la maggior parte dei tool per fare dei test A/B, è dell’80%.

Questo ci dice dunque che non esistono solo dei falsi positivi, ma anche dei falsi negativi, ovvero dei test che, arrivati alla fine, non riescono a mostrarci un vincitore – anche quando questo esiste.

Fattori esterni che possono minacciare l’affidabilità di un test

Non tutti i momenti sono uguali per lanciare un test A/B, e per questo è necessario tenere attentamente in considerazione il giorno in cui si lancia il confronto. Ecco per esempio delle date che, ovviamente, vanno considerate come speciali, praticamente per qualsiasi tipo di e-commerce:

- I giorni prima di Natale

- Black Friday (e, sempre di più, anche il Cyber Monday)

- Evento aziendale

- Il lancio di una campagna

- Il giorno della settimana (c’è differenza tra il lanciare un test di lunedì o di venerdì)

Ma cosa vuol dire affermare che queste giornate devono essere considerate come speciali? Significa che la pagina che un test A/B ha individuato come vincitrice durante i giorni precedenti il Black Friday o durante la settimana prima di Natale può risultare come perdente nei giorni successivi, invalidando così i risultati del tuo test.

Qual è dunque la soluzione?

Pensi che l’unica possibilità sia quella di non effettuare alcun test A/B in occasione di questi giorni anomali?

In realtà è possibile effettuare test A/B significativi anche in corrispondenza di queste date peculiari, avendo però l’accortezza di preventivare gli effetti indotti solo e unicamente dall’evento in sé, oltre che di includere il maggior numero possibile di fonti di traffico

Partire da un’ipotesi, non da una semplice idea

Ogni test A/B deve partire da una solida e ben esposta ipotesi, e non su una semplice idea.

Quale differenza c’è tra questi due concetti? Ebbene, un’ipotesi è misurabile, un’idea assolutamente no.

Ma come si struttura una robusta ed efficace ipotesi?

Per formulare un’ipotesi che si possa definire scientifica si può usare uno schema molto semplice ma allo stesso tempo molto incisivo, proposto qualche anno fa da Craig Sullivan, ovvero:

Ecco, se il tuo proposito può essere presentato seguendo fedelmente questo schema, esso può essere assunto a tutti gli effetti come un’ipotesi scientifica.

Gli strumenti per i test A/B sul tuo e-commerce

Pur sottolineando che nessuno strumento, nemmeno il più avanzato, può fare l’analisi dei dati per noi – e che quindi, in ogni test A/B, è necessario mettere del proprio, ecco una ristretta selezione di tool che devi conoscere per poter aumentare le conversioni sul tuo e-commerce

Google Optimize

Qualcuno si ricorderà che, nel 2012, Google ha integrato nel suo Analytics uno strumento dal nome ‘Esperimenti di Analytics’, il quale, va detto non aveva raccolto molti commenti entusiasti. La sua evoluzione, ovvero Google Optimize, venne poi inserita nella versione a pagamento di Google Analytics. A partire dal 2017, per la gioia dei più, Optimize è disponibile – seppur con qualche limitazione – anche gratuitamente. Il suo vantaggio? Beh, oltre all’essere gratuito, lavora in parallelo con il suo ‘genitore’ Analytics. Vedi lo strumento

VWO

Per chi vuole uscire dall’ambiente Google ma non vuole alzare l’asticella della difficoltà, VWO è la giusta soluzione. I risultati sono presentati in modo molto intuitivo, anche per i non esperti. Vedi lo strumento

Convertize

Io che lavoro nel campo del neuromarketing applicato al web adoro questo strumento. Convertize unisce al servizio di A/B test una serie infinita di suggerimenti e moduli dinamici già collaudati, basati sulle più importanti regole di persuasione, psicologia comportamentale e user experience. Se ti piacciono gli strumenti che oltre a fornire servizi ti consigliano anche in modo pro-attivo allora non lasciartelo scappare. Vedi lo strumento

Altri strumenti: altri due popolari tool per fare test A/Bing sono Optimizely e Visual Website Optimizer, entrambi Freemium.

Finalmente: ecco come interpretare i risultati dei test A/B

Tra le difficoltà legate ai test A/V per e-commerce non vi sono unicamente quelle legate alla creazione dei test. Una particolare attenzione va infatti posta anche all’interpretazione dei risultati, i quali – se la costruzione e la gestione del test sono state fatte a regola d’arte – sono sempre molto istruttivi, anche quelli ‘negativi’.

Persino i dati relativi ad una variante nettamente perdente, infatti, possono essere utili, anzi, talvolta i report relativi ad una pagina ‘sconfitta’ possono fare la differenza per le definizione delle strategie successive. Capisci dunque quanto è importante allargare il proprio sguardo anche alle varianti meno fortunate, evitando di concentrarsi unicamente sulle pagine vincenti: mai come in questo caso, infatti, è stata vera la massima ‘sbagliando si impara’.

Nella stragrande maggior parte dei casi quindi, anche le varianti perdenti hanno un qualche punto forte da non trascurare. L’importante è sapere dove guardare, analizzando tutti i diversi segmenti di pubblico.

Non limitarti dunque a guardare solamente i nuovi visitatori, ma vai oltre, filtra gli utenti da mobile, gli utenti iOS, gli utenti Android, gli utenti Desktop, gli utenti Chrome, gli utenti Safari, gli utenti da tablet, gli utenti da smartphone, gli utenti da ricerca organica, gli utenti da annunci a pagamento, gli utenti provenienti dai social e via dicendo.

Anche una variante nettamente perdente può avere un dato spiccatamente positivo riguardo ad uno o più di questi segmenti: fare dei test senza analizzare questi aspetti significa non sfruttare appieno il potenziale del test.

Perché e come archiviare i test A/B

Chi vuole davvero migliorare le conversioni del proprio e-commerce esegue tanti, tantissimi test A/B nel tempo, su un gran numero di pagine e su uno sterminato numero di elementi. Alla lunga però, il rischio è quello di perdere il filo dei test già effettuati, arrivando magari a ripetere degli esperimenti che in realtà avevano già trovato risposta certa nei test precedenti.

Per evitare di sprecare tempo prezioso è dunque necessario che tu tenga traccia dei test A/B effettuati sul tuo e-commerce. Le soluzioni, in questo caso, sono differenti, alcune più specialistiche, alcune più terra-terra: se organizzata a dovere, anche una semplice tabella Excel può fare un buon lavoro, mentre se vuoi qualcosa di più specifico puoi provare un tool come Effective Experiments.

L’essenziale, in ogni caso, è memorizzare questi elementi:

- l’ipotesi di partenza

- la pagina di controllo

- la variazione

- la versione vincente

- i dati di insight

Di mese in mese questo archivio diventerà sempre più ricco e sempre più utile per creare delle nuove tattiche.

Ecco, ora tocca a te: quale sarà il primo test A/B del tuo e-commerce?

Parlaci del

Parlaci del